Test statistici in psicologia: guida completa per l'università

Schemi sui test statistici in psicologia. I Riassunti, pensati per studenti universitari di Psicologia, offrono una guida concisa ai test statistici, includendo t di Student, ANOVA, correlazione e regressione lineare, con dettagli su assunzioni e modelli statistici.

Mostra di più20 pagine

Visualizza gratis il Pdf completo

Registrati per accedere all’intero documento e trasformarlo con l’AI.

Anteprima

SIGLA E NOME

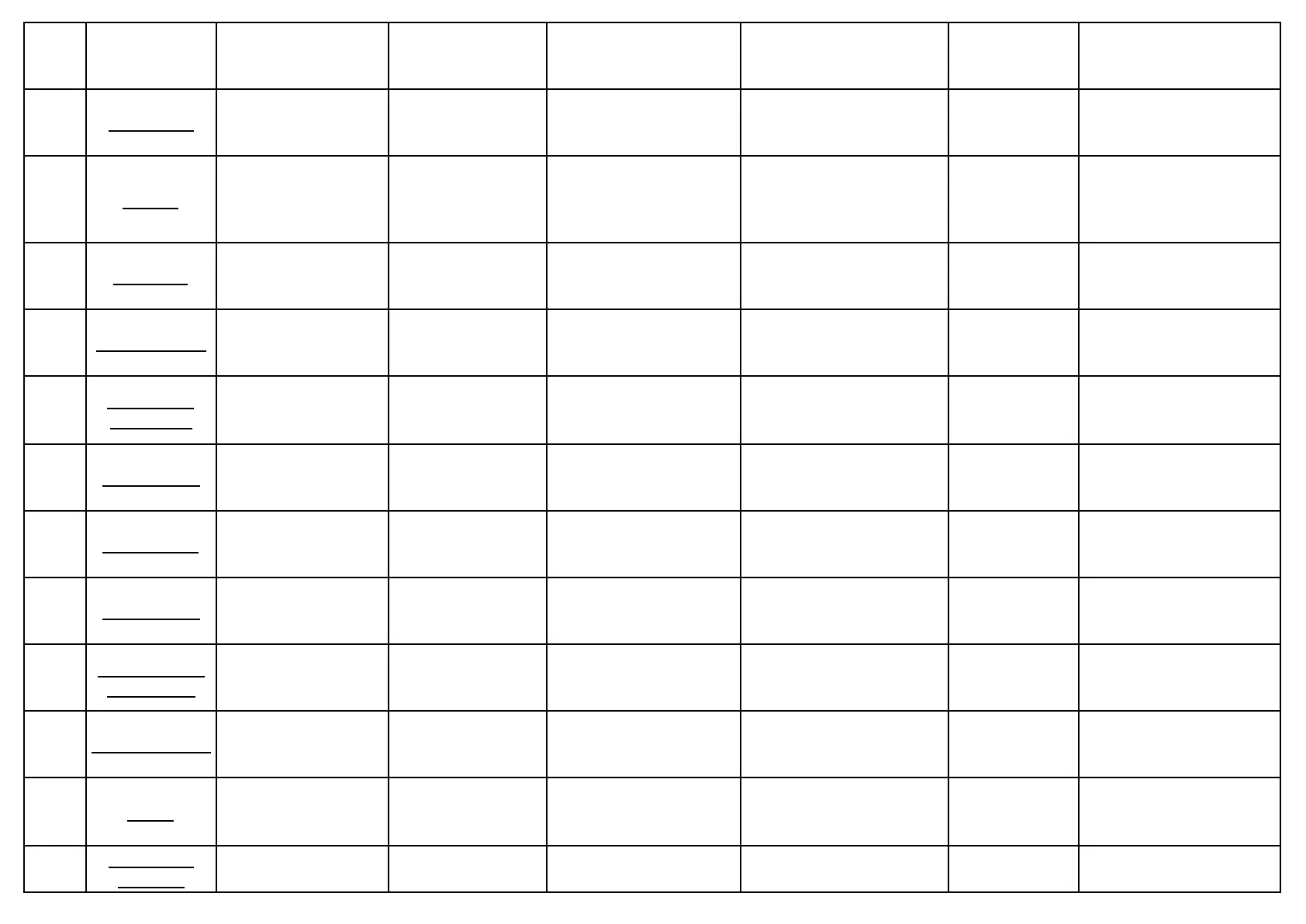

SIGLA NOME CHE COS'È / A COSA SI RIFERISCE COME SI TROVA IN JAMOVI COME SI LEGGE QUANDO USARLA QUANDO È SIGNIFICATIVA SE E' = 0 / 1 / >.05?

T di Student

t t di Student Indica quanto è grande la differenza tra due medie TABELLA t-test - colonna "t" "t = 2.5" -> differenza tra gruppi presente Quando confronti 2 gruppi Se p < . 05 t = 0 = no differenza t > 2 = controlla p

P-value

p p-value Probabilità che il risultato sia dovuto al caso Sempre accanto a t, F, x2 "p = . 03" -> c'è solo il 3% di possibilità che sia casuale In tutti i test inferenziali Se <. 05 p > .05 = non significativo p = 0 = effetto fortissimo p = 1 = 100% casuale

F di Fisher

F f di Fisher Differenza tra 3 o più medie (ANOVA) TABELLA ANOVA -> colonna "F" "F = 4.6" -> differenze tra i gruppi esistono Quando confronti più di 2 gruppi Se p <. 05 F = 1 = no differenza F > 3 = verifica p

Gradi di libertà (df)

df Gradi di libertà Dipende da quanti partecipanti e gruppi hai Accanto a t, F, x2 – In tutti i test, ti dice quanto è robusto il test Non ha soglia specifica df basso = meno potenza df alto = più affidabilità

Intervallo di confidenza (CI)

Cl Intervallo di confidenza Intervallo in cui probabilmente si trova il vero valore Colonna "CI 95%" "CI 95% = [0.2, 0.9]" -> il valore reale è tra 0.2 e 0.9 Quando confronti medie o effetti Se NON contiene 0 Se include 0 -> NON significativo

Eta quadrato (n2)

n2 Eta quadrato Indica la dimensione dell'effetto (quanto è forte) Colonna "n2" in ANOVA "n2 = . 12" -> effetto abbastanza grande Dopo ANOVA, per sapere se l'effetto è piccolo o grande .01 = piccolo .06 = medio . 14 = grande n2 = 0 = nessun effetto n2 = 1 = effetto totale

Correlazione (r)

r Correlazione Quanto sono collegate due variabili TABELLA correlazione -> colonna "r" "r = . 45" -> correlazione moderata Quando studi la relazione tra due variabili Se p < . 05 r = 0 = no relazione r = 1 = perfetta

Chi quadrato (x2)

x2 Chi quadrato Serve per dati categoriali Output x2 "x2 = 6.5" -> differenze tra frequenze Quando confronti frequenze attese vs osservate Se p < . 05 x2 = 0 = nessuna differenza

Coefficiente di regressione (β)

β Coefficiente di regressione Quanto predice una variabile sull'altra Output regressione -> colonna "B" "B = 0.7" -> per ogni punto in X, Y aumenta di 0.7 Quando usi regressione Se p < . 05 B = 0 -> non predice ß alto -> predice forte

Errore standard (SE)

SE Errore standard Quanto è precisa una media o un coefficiente Accanto a M o B "SE = 0.1" -> media è stimata con alta precisione Per valutare l'affidabilità di media o ß SE grande = più incertezza

Media (M)

M Media Valore medio di una variabile TABELLA descrittive -> colonna "M" "M = 3.5" -> media del gruppo = 3.5 In tutti i confronti o descrizioni – = 0 -> nessuna differenza tra gruppi

Deviazione standard (SD)

SD Deviazione standard Quanto sono sparsi i dati Colonna "SD" nelle descrittive "SD = 1.2" -> dati distanti 1.2 dalla media Quando vuoi sapere la variabilità interna – SD = 0 = tutti uguali SD alta = molta variabilità

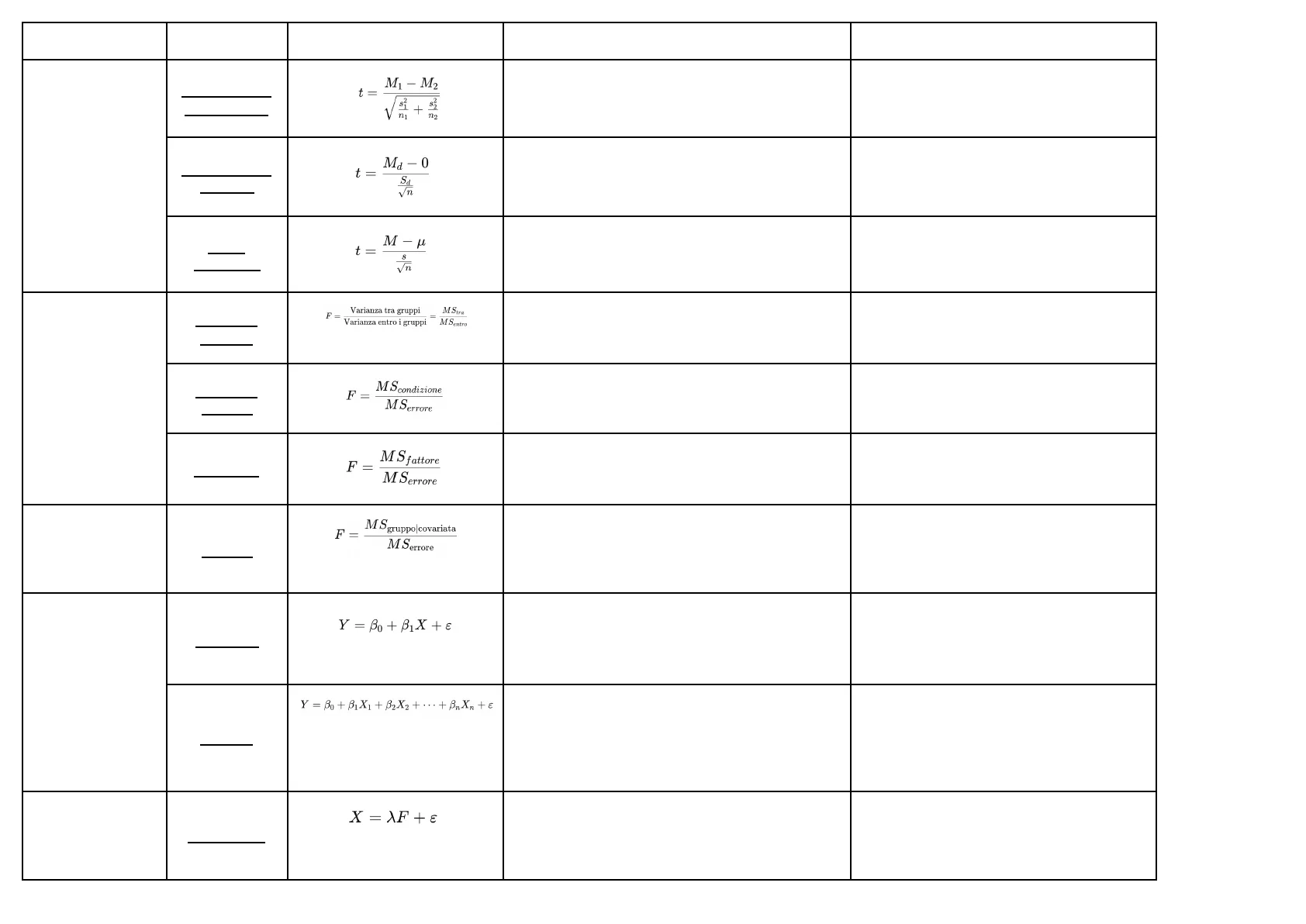

NOME, TIPOLOGIA, FORMULA E ASSUNZIONI

T-TEST

- Per campioni

indipendenti

M1 - M2

t =

Vi + %

Per verificare se due gruppi differiscono

- Normalità dei dati in ciascun gruppo

- Omogeneità delle varianze

- Indipendenza delle osservazioni

- Per campioni

appaiati

t =

Ma - 0

Per vedere se c'è cambiamento entro i soggetti

- Normalità delle differenze tra i due tempi

- Assenza di outlier estremi

- Per 1

campione

t =

8

Per capire se il gruppo differisce da un valore

teorico

- Normalità dei dati

ANOVA

- One-way

ANOVA

Varianza tra gruppi

MStra

Per testare se almeno un gruppo è diverso

- Normalità in ciascun gruppo

- Omogeneità delle varianze

- Indipendenza delle osservazioni

- A misure

ripetute

MScondizione

F =

M Serrore

Per studiare cambiamenti entro soggetti

- Sfericità (test di Mauchly)

- Normalità

- Assenza di outlier estremi

- Fattoriale

F =

MS fattore

M Serrore

Per testare effetti principali + interazione

- Normalità dei dati per ciascuna cella

- Omogeneità delle varianze

- Indipendenza delle osservazioni

ANCOVA

- Ancova

M S gruppo|covariata

F =

M Serrore

Per rimuovere l'effetto di una variabile continua

- Linearità tra covariata e DV

- Omogeneità delle regressioni

REGRESSIONE LINEARE

- Semplice

Y = Bo + B1X+8

Per predire Y da X

- Normalità dei residui

- Omogeneità delle varianze

- linearità della relazione

- Indipendenza degli errori

- Normalità degli errori

- Omoschedasticità

- Multipla

Y = Bo + B1X1+ B2X2 + ... + BnXn +8

Per vedere l'effetto di più predittori insieme

- Linearità

- Assenza di multicollinearità

- Normalità degli errori

- Indipendenza degli errori

- Omoschedasticità

ANALISI FATTORIALE

- Esplorativa

X=XF + &

Per ridurre dimensioni e trovare costrutti latenti

- Linearità tra le variabili

- Normalità multivariata

- Adeguatezza campionaria (KMO > .6)

- Bartlett significativo (p < . 05)

NOME, TIPOLOGIA, COS'È, QUANDO USARLO E COME RICAVARLO SU JAMOVI

T-TEST

- Per un

campione

verifica se la media di un

campione differisce da un valore

noto (es. media teorica)

confronto tra media di un solo gruppo e

un valore di riferimento.

- Vai su Analisi > T-Test > T-Test per un campione

- Inserisci la variabile numerica

- Inserisci il valore con cui vuoi confrontare (es. 100)

- Seleziona media, IC, grafici, ecc.

- Per

campioni

indipendenti

confronta le medie di due gruppi

distinti.

confronto tra due gruppi non legati (es.

maschi vs femmine).

- Vai su Analisi > T-Test > Campioni indipendenti

- Trascina la variabile di gruppo nel box Gruppo

- Trascina la variabile dipendente (continua)

- Spunta opzioni (IC, Welch, varianze uguali ... )

- Per

campioni

appaiati

confronta le medie di due misure

sullo stesso gruppo.

pre/post test, stesso gruppo in due tempi

diversi.

- Vai su Analisi > T-Test > Campioni appaiati

- Seleziona le due variabili (misurazioni ripetute)

- Spunta le opzioni desiderate

ANOVA

- One-way

anova

confronto tra le medie di 3 o più

gruppi indipendenti.

un solo fattore con ≥3 gruppi (es. livelli di

stress in tre classi diverse).

- Vai su Analisi > ANOVA > ANOVA

- Inserisci variabile continua (dipendente)

- Inserisci variabile categoriale (indipendente)

- Spunta Post-hoc se vuoi vedere quali gruppi differiscono

- A misure

ripetute

ANOVA dove lo stesso soggetto è

misurato più volte.

test ripetuti sullo stesso gruppo (es.

prestazione a 3 tempi diversi).

- Vai su Analisi > ANOVA > Misure ripetute

- Crea un Fattore con i nomi delle condizioni

- Seleziona le variabili corrispondenti (es. tempo 1, tempo 2 ... )

- Aggiungi grafici, confronti post-hoc, etc.

- Fattoriale

valuta l'effetto di 2 o più fattori

indipendenti e la loro interazione.

più variabili indipendenti (es. genere e

condizione).

- Vai su Analisi > ANOVA > ANOVA

- Inserisci variabile dipendente

- Inserisci più variabili indipendenti (fattori)

- Spunta interazioni e post-hoc

ANCOVA

- Ancova

ANOVA che controlla anche una

variabile continua (covariata).

quando vuoi confrontare gruppi

controllando per un'altra variabile (es.

confrontare livelli di ansia tra gruppi

controllando per l'età).

- Vai su Analisi > ANOVA > ANCOVA

- Inserisci variabile dipendente

- Fattori (gruppi)

- Covariata (es. età)

REGRESSIONE LINEARE

- Semplice

modello che spiega una variabile

dipendente con una sola

predittore.

prevedere un risultato (es. rendimento

scolastico in base alle ore di studio).

- Vai su Analisi > Regressione > Regressione lineare

- Inserisci variabile dipendente (Y)

- Inserisci una variabile predittore (X)

- Spunta coefficiente, R2, diagnostica, ecc.

- Multipla

come la semplice, ma con più

predittori.

più variabili spiegano la stessa cosa (es.

rendimento spiegato da ore di studio,

ansia, motivazione).

- Come sopra, ma inserisci più predittori

- Controlla multicollinearità (VIF), significatività individuale

- Interpreta R2 (spiegazione totale) e ß (effetti singoli)

ANALISI FATTORIALE

- Esplorativa

tecnica per identificare strutture

latenti dietro a un insieme di

variabili (es. trovare "fattori" dietro

20 item di un questionario).

per ridurre dimensioni o scoprire fattori

nascosti in scale/questionari.

- Vai su Analisi > Fattoriale > Esplorativa (EFA)

- Inserisci le variabili (item/questionario)

- Scegli metodo (es. Principal Axis Factoring)

- Seleziona numero di fattori o lascia automatico (Kaiser)

ARGOMENTO, TERMINE E DEFINIZIONE

Modello statistico

Modello statistico una rappresentazione efficiente e compatta dei dati raccolti per descrivere un fenomeno empirico

Media

Media sommatoria di tutti i nostri valori diviso il numero dei valori

Varianza

varianza rappresenta l'errore che commettiamo mediamente se usiamo la media come modello statistico di un campione

Deviazione standard

deviazione standard valore che mi rappresenta l'errore usando l'unità di misura della variabile di partenza

PRINCIPI DI CAMPIONAMENTO E STIME CAMPIONARIE

- Popolazione insieme dei casi o delle persone a cui si vogliono generalizzare le conclusioni dell'indagine

- campione statistico rappresentando una frazione della popolazione che deve essere rappresentativo ed efficiente

- errore di stima / errore standard Indica l'errore attore che facciamo nell'utilizzare un campione (con data numerosità e variabilità) per stimare una caratteristica della popolazione

MISURAZIONE

- misurazione permette di esprimere, attraverso dei simboli, le caratteristiche delle unità di analisi, che vanno divise in quantità e qualità e che presentano caratteristiche di tipo variabile o costante

- Regola che mi permette di assegnare in modo sistematico dei numeri a degli oggetti o eventi

- Scale di Misura Nominale: categorie senza ordine. Ordinale: categorie con ordine, ma le distanze non sono precise. Intervallo: numeri con ordine e distanze uguali, ma senza zero assoluto. Rapporto: numeri con ordine, distanze uguali e zero assoluto.

organizzazione dei dati in tabelle

- Tabelle di frequenza

- X: valori che può assumere la variabile

- F: frequenza di ogni valore

- N: totale delle osservazioni

- assoluta: numero di unità statistiche che presentano un dato valore

- relativa: numero di unità statistiche che presentano un dato valore -> % di elementi che hanno un determinato valore

- cumulativa: frazione di unità statistiche che rappresentano una data modalità minore o uguale a quella corrente

- Seriazioni statistiche

se il carattere presenta molte modalità distinte può essere conveniente accorpare le modalità in classi, che devono essere:

- disgiuntive: un numero può entrare in una sola categoria

- esaustive: devono contenere tutti i numeri

- Chiuse a destra: è incluso solo il limite superiore

- frequenze simbologia: